从开放生态到技术破局,昇腾CANN筑实AI时代的创新基座

- +1 你赞过了

【天极网IT新闻频道】从“百模大战”到“头部+垂直”的市场格局,大模型技术的发展经历了技术竞赛、资源整合、生态成熟的深刻转变。如今,企业已经不再一味地追求超高算力、超大参数模型的构建,而是将重点放到了应用场景的实践探索上。

在这样的背景之下,AI开放生态的建设变得尤为关键。一方面,开放的生态可以吸引更多的开发者加入进来,更好地推动技术创新,让技术能够更快地迭代,大幅提升企业的开发效率;另一方面,开放的生态能够将企业和开发者汇聚一堂,共同探索AI在不同场景下的应用创新,集众家智慧于一体,加速AI在不同领域的应用,更快地推动AI的普及。

然而,现阶段企业和开发者在构建易用、好用的大模型应用过程中,还将面临生态碎片化造成的创新壁垒、模型训练与推理效率低下引发的成本攀升、硬件潜能释放不足导致的算力浪费三大核心痛点。如何应对?怎么破局?华为昇腾异构计算架构CANN,成为破解AI应用开发和场景化落地挑战的关键密钥。

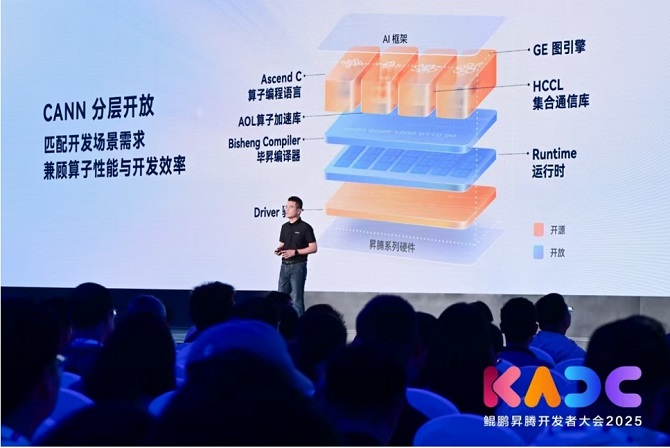

华为昇腾计算业务总裁张迪煊

在鲲鹏昇腾开发者大会2025上,华为昇腾计算业务总裁张迪煊揭晓了昇腾CANN的核心能力。作为昇腾AI的核心平台,昇腾CANN正通过深度开放与原子级创新,构建了全栈开放生态、高能效的算力底座,为中国AI开发者打造了“软硬协同”的创新引擎,夯实了大模型时代的创新基座。

从开源共建到人才培养,开放生态使能每一位创新者

真正的伟大,从不诞生于孤岛。而技术的高度,*终将由生态的广度与活力来丈量。

在打造硬核技术能力的同时,昇腾CANN正以"使能每一位创新者"为核心理念,通过"基础层开放+应用层共创"的双轮驱动模式,为企业和开发者打造易用、好用的开发平台,全力推动国产AI产业链的协同进化,形成了从技术突破到商业转化的生态闭环。

在基础层面,昇腾CANN实现了鸿蒙、欧拉、麒麟、红旗、统信五大国产系统的深度链接,为生态伙伴提供灵活高效的硬件定制开发支持。在技术层面,昇腾CANN分层解耦架构在关键领域取得了突破性进展。高性能算子库已使能30余家客户/伙伴开发260+核心算子,驱动整网性能平均提升超10%;通信算法创新方面,基于pipeline算法、NHR核算法等前沿技术实现通信效率跃升50%+,助力10余家企业突破分布式训练瓶颈。

除了基础层面的开放合作与技术层面的创新之外,在应用层,昇腾CANN与企业进行深度合作,共同打造创新性的应用。例如,在用户比较关注的整图优化技术方面,昇腾CANN与20+行业领军企业深度协同,通过创新性的应用调度加速、内存复用等六大优化策略,实现了内存占用压缩25%、推理性能提升了20%的显著突破。

另外,在加速引擎创新维度,CANN已经支持硅基流动等10余家AI基础设施企业打造的差异化解决方案,成功孵化了智能调度引擎、分布式训练框架等创新套件,构筑起覆盖模型开发、训练加速、部署优化的全链路技术生态。

除此之外,昇腾CANN还积极与高校进行开放合作,共同推动科研成果的落地。2020年底,由教育部、华为联合发起了“智能基座”产教融合协同育人基地项目,首批布局了72所高校,将CANN相关知识纳入校园课程,通过深化信息技术领域人才培养模式改革和协同创新,着力构建以信息技术领域关键核心技术为基础的产业与人才生态。

目前,昇腾CANN已经与清华大学、北京大学、上海交通大学等顶尖高校合作,打造了卓越中心和孵化中心,针对前沿的创新课题孵化世界级的科研项目,引领AI的创新发展。

大会现场,华南理工大学计算机科学与工程学院教授、博士生导师陆璐教授展示了团队开发的算子以及参数调优等性能优化的手段。基于昇腾算子模板库CATLASS,算子开发过程中有大量可以复用、拼装的开源代码实现,通过参数修改可以快速调整切分策略,高效实现性能寻优。陆教授指出,只要熟悉昇腾编程平台,掌握了其体系架构,很多应用就能够在昇腾平台中顺利地运行起来。通过不断优化,能够将性能从50%提升到100%,甚至在某些应用场景下,性能能够提升200%到500%。在这期间,团队也参与到了开源模板库CATLASS的建设,大幅提升开发者的开发效率。

除了与企业和高校的合作之外,昇腾CANN同样重视个人开发者的培养。天津理工大学电气工程与自动化学院人工智能专业2022级学生王富平,从2023年开始参加昇腾AI创新大赛,在昇腾CANN异构计算架构等领域进行了研究探索,不但通过大赛学习到了*前沿的技术,收获了诸多的创新成果,而且成为了天津市首位华为开发者布道师,首届“求实创新班”成员。

张迪煊在主题演讲中表示,目前,华为已经累计培养了40多万名学昇腾、懂昇腾的学生,很多学生已经进入社会,进入企业,成为推动AI发展的中坚力量。

昇腾CANN与企业、高校科研机构的生态合作,很好地促进了双方的共同成长,并给产业创造了巨大的商业价值。而且通过创新大赛等形式,实现了对个人开发者的培养,为社会输送了一大批优秀的创新人才,为中国科技的发展带来了极其深远的影响。

根据昇腾官方数据统计,6年来,有超过60万开发者了解CANN、使用CANN、赋予CANN创新活力。在昇腾CANN持续推进开放,以及产业各方开发者、企业积极参与之下,CANN生态正在快速成长。目前CANN的算子认证开发者已经超过了6000人。

截至目前,基于昇腾NPU+昇腾CANN技术生态所能实现的AI应用性能,已经能够比肩CUDA,并且在开放的广度、深度上,都比CUDA更进一步。取得如此辉煌的成绩,昇腾CANN仅仅用了6年时间,创造了科技界的一个奇迹。

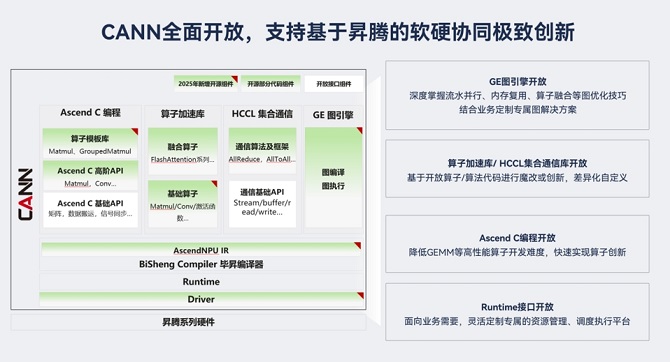

如今,从Ascend C算子编程语言、AOL算子加速库、GE图引擎、HCCL集合通信库、毕昇编译器、Runtime运行时到Driver驱动,昇腾CANN正在通过不断丰富高层、底层组件,进一步充实开发者们的弹药库,以全面开放支持基于昇腾的软硬协同极致创新。

不难发现,在"基础层开放+应用层共创"的双轮驱动模式,昇腾CANN不仅重塑了AI算力效能边界,而且推动了国产AI产业链的协同进化,形成从技术突破到商业转化的生态闭环。目前,昇腾CANN已成为中国开发者生态*活跃、技术迭代*迅猛的AI创新平台,持续以开放生态与全栈赋能,引领智能算力时代。

构建差异化开放策略,用分层架构赋能AI场景化创新

当用户需求以天为单位迭代更新,当产品迭代周期从“年”压缩到“周”,当算法迭代以天为单位,每一分钟的效率提升都可能转化为商业战场的制胜先机。

打造高效的开发机制,不仅是企业内部需要解决的挑战,更是华为昇腾CANN的使能所在。在去年的昇腾AI开发者峰会,昇腾宣布了深度开放策略,通过构建覆盖算子开发、系统调优到编译链优化的全场景赋能体系,赋能开发者基于昇腾进行大模型原生创新;7月份,昇腾CANN关键的高层组件开放代码到Gitee社区,客户和合作伙伴正式拉开了自主创新之路。

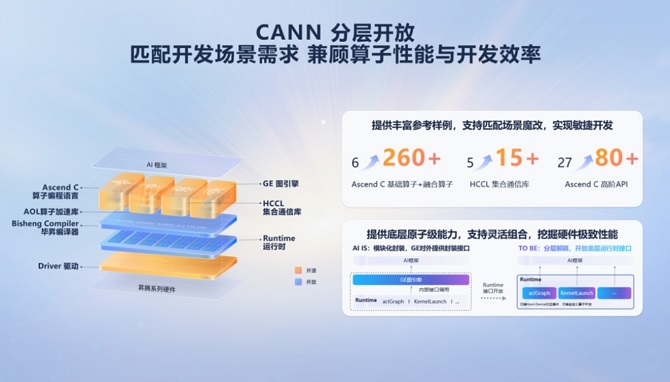

为了让不同技术能力的开发者都能够简单、高效地开发创新应用,昇腾CANN通过匹配不同的场景,打造了分层开放的架构,通过算法创新层、系统优化层和编译生态层三层架构的差异化开放策略,赋能开发者基于场景化的AI应用创新。

在算法创新层,通过开源FlashAttention、Matmul等核心算子及MESH/RING通信算法的*佳实践代码库,使开发者可基于业务场景进行"魔改式"创新。

大会现场,张迪煊以华南理工大学团队的开发案例进行了详细介绍。据了解,华南理工大学团队利用全新发布的CATLASS算子模板库开发Matmul算子,开发周期从传统4人周压缩至2人周,并通过参数动态调优实现20%+性能增益,开创了"开发即优化"的新模式。

在系统优化层,CANN开放190+底层原子接口,实现硬件能力的颗粒化释放。清华大学计图团队联合昇腾研发的MoE专用算子体系,通过调用aclGraph模型调度接口与INT4量化技术,成功将DeepSeek R1模型的推理时延降低50%,验证了原子能力组合创新的巨大潜力。

在编译生态层,CANN与Triton框架的深度整合引发开发范式变革:通过开放毕昇编译器的AscendNPU IR接口,开发者可直接使用Python语法编写高性能算子,底层硬件差异被完全抽象化。同时提供的编译层控制接口,使第三方框架能定制化调整数据流编排策略,在智能医疗影像分析等场景中实现编译效率提升40%。

实际上,实行分层架构是昇腾CANN一直坚持的开放模式,能够让开发者针对不同的场景进行需求匹配,实现性能与开发效率的双重兼顾。丰富的参考样例能够很好地匹配场景魔改,实现敏捷开发和高效开发。此外,底层原子级能力支持灵活组合,让开发者可以更好地挖掘硬件性能。

"三驾马车"协同创新,核心技术让AI创新跑出+速度

当MoE架构成为大模型主流,当单日推理Token量突破10万亿,当企业争相部署千亿参数模型——AI产业在狂飙突进的同时,也深陷计算性能、开发效率与生态协同的三重围城。

众所周知,硬件是构筑AI算力的基石底座。从硅晶圆上的微观电路到数据中心里的庞大阵列,硬件架构的持续创新为AI技术提供了强大算力支撑。随着AI技术的持续突破,模型优化技术从“模型结构创新”延伸到“训推全流程”的算法创新,利用底层硬件资源,通过在核心技术上的持续突破,昇腾CANN在计算、内存、通信三个维度持续释放硬件价值,用“三驾马车”重构AI算力。

在计算层面,针对MoE大模型训练场景的"卡脖子"难题,CANN创新性推出超级算子MLAPO:通过Vector与Cube计算单元并行化改造,将原本13个串行小算子融合为统一融合大算子,成功将MLA前处理耗时从行业平均109us压缩至45us,在蚂蚁金融风控模型、腾讯广告推荐系统中实现20%+端到端性能提升,破解了Transformer架构的算力瓶颈。

在内存层面,面对动态shape场景的"内存碎片化"痼疾,CANN研发的多重地址映射技术犹如为内存系统植入"智能中枢":通过物理内存动态切分与虚拟地址智能适配,实现内存碎片的自动化拼接利用,使京东商品搜索、腾讯短视频推荐等业务场景的内存利用率跃升20%以上,单卡可承载的并发请求量突破行业极限。

在分布式训练领域,CANN打造的NPUDirect通信算法彻底改写游戏规则:通过NPU Vector核直控数据传输,将传统RDMA通信所需的3次同步精简为1次原子操作,使得科大讯飞语音大模型的跨机通信时延骤降90%,中国移动的千卡集群通信效率提升50%,开创了万卡级分布式训练的可行性路径。

值得关注的是,昇腾CANN+昇腾NPU的组合,无论是在效率还是成本方面,都实现了与海外主流算力平台的快速看齐,在某些领域甚至实现了超越,彻底打破了海外算力平台独大的格局。

大会现场,科大讯飞副总裁、AI工程院院长潘青华展示了讯飞和昇腾的合作成果。据介绍,今年3月,讯飞基于昇腾算力率先实现了MoE模型大规模跨节点并行集群的推理,推理性能提升了3倍。

除此之外,AI Infra的无问芯穹采用了昇腾平台,并基于昇腾CANN进行深度优化创新,针对大模型推理集群部署中的通信开销问题进行技术攻关,实现单算子性能提升20%,显著降低了算力资源的消耗。

可以看出,通过技术上的持续创新,昇腾CANN不仅实现了单点性能的指数级提升,更构建起"芯片级优化-系统级调度-集群级协同"的全栈能力,这也标志着AI算力技术正式迈入"原子级精准调优"的新纪元。

写在*后:用技术创新+生态开放夯实AI时代的创新基座

从分层开放的技术架构到产学研生态协同创新,再到计算、内存、通信等领域的底层技术突破,昇腾CANN始终坚持着技术创新和开放生态两手抓的理念,在不断优化底层技术的同时,以全栈开放的姿态与产学研合作伙伴携手创新,不断地为开发者提供好用、易用的产品和解决方案,为企业AI应用创造无限的价值,为AI产业发展提供了新的动力。

展望未来,昇腾CANN将通过不断丰富高层、底层组件,为开发者们提供更加丰富的弹药,并通过开放的生态建设,为开发者的AI创新全力赋能。

类型:广告最新资讯

热门视频

新品评测

X

X

微博认证登录

微博认证登录

QQ账号登录

QQ账号登录

微信账号登录

微信账号登录